近年AIやロボットの進展が目覚しく、毎週のように新しい研究やニュースが報告されています。私たちは目や耳など五感を通して世界を見ていますが、ロボットから見た世界はどのようなものでしょうか?

組込みシステムの仕組み

本題に入る前に私のもう一つの専門である組込みシステムについてもお話しておきます。組込みシステムとは、家電や自動車などに組み込まれたコンピュータシステムで、例えばエアコンなら指定された温度になるように、部屋の温度を測りながら出力を制御しています。パソコンやサーバで使われるコンピュータはさまざまな用途に使えるようにいろいろなアプリケーションを導入して利用しますが、組込みシステムは特定の用途に特化した小型で低消費電力なコンピュータを利用します。

また組込みシステムはさまざまなセンサを通して、環境のさまざまな情報を取り入れて計算し、アクチュエータを介して出力するため、外部の環境をより意識する必要があります。ロボットもまたさまざまなセンサやアクチュエータを搭載した組込みシステムとも言えます。

センサから情報取得

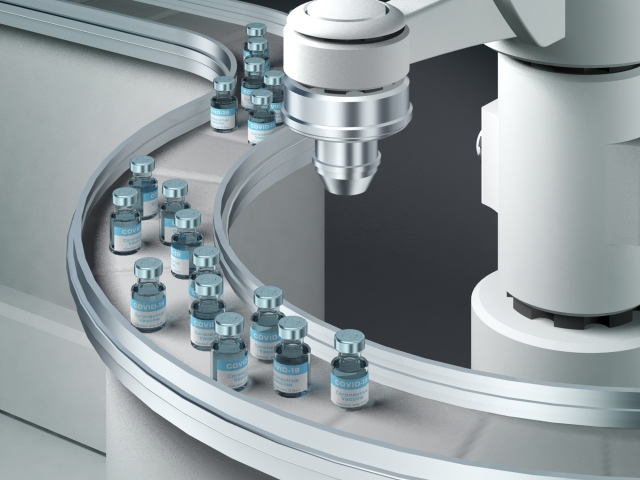

ロボットもセンサを通して世界を見ています。カメラなら画像、マイクなら音といったように搭載されているセンサごとに異なる情報を取得することができます。また、赤外線や超音波などの人には感知できないものを捉えることや、レーザーを使って距離を正確に測るといったことも可能です。工場などで使われるアームロボットの多くはカメラを搭載していないため、当然ながら搭載されていないセンサの情報は取得できず、周りの景色を知ることができません。

環境情報の共有

目の前にこの新聞があるかと思いますが、目を閉じたまま手を膝の上まで戻してから、新聞のページをめくってみてください。うまく出来たでしょうか?次は目を閉じて部屋の中にあるものを思い浮かべてください。目を閉じたとしても、皆さんの記憶の中に部屋の中の物や位置、さらには温度や手触りまで複数の感覚器で捉えた地図が記憶されており、思い返しながら動くことができます。また膝の上に手を戻す動作はスムーズに行えたと思います、これは脳が身体の構造や腕の曲がり具合をすべて把握しているためです。

ロボットを高度に制御したり、複数のロボットを連携したりするためには、このような情報を織り交ぜた高度な地図情報が必要となります。屋内でロボットを行動させる際には、LIDARと呼ばれるレーザーで周囲の形状を測位するセンサを使って、移動しながら地図を作り自身の位置を特定しています。人同士では頭の中の地図を直接やり取りすることは難しいですが、ロボットや組込みシステムであれば、地図データを渡すことも、現実世界を映しとった仮想空間を作ることも可能です。この仮想空間がロボットの見る世界ともいえますし、開発者がロボットに見せたい世界でもあります。現状ではロボット間の協調は限られたものですが、今後の仮想空間を通じてより高度な動きを見せるロボットも増えてくるでしょう。

街中でもロボットを見かけることが多くなってきました。ぜひ身近なロボットがどのようなセンサを搭載し、どのような世界を見ているか想像してみてください。

埼玉新聞「知・技の創造」(2025年2月7日号)掲載

細合 晋太郎(ほそあい しんたろう)

情報メカトロニクス学科講師

北陸先端科学技術大学院大学博士課程修了。博士(情報科学)。株式会社チェンジビジョンを経て2024年4月より現職。

専門はロボットおよび組込みシステム。